合成データ(Synthetic Data)が開く4つの主要活用領域

目次

2025年、生成AIの進化は留まることを知らず、ビジネスのあらゆる場面でその活用が模索されています。しかし、AI開発の現場では、常に「データの壁」という大きな課題が立ちはだかります。AIモデルの性能は、学習に用いるデータの質と量に大きく依存しますが、高品質な実データを大量に、かつ継続的に入手することは容易ではありません。この根深い課題を解決する鍵として、今、世界的に注目を集めているのが「合成データ(Synthetic Data)」です。本記事では、この合成データとは何か、なぜ重要なのか、そしてビジネスでどのように活用できるのかを、最新の動向を踏まえながら徹底解説します。

1. はじめに:データ活用の新たなフロンティア「合成データ」とは?

1-1. なぜ今、合成データが注目されるのか?

合成データが急速に重要性を増している背景には、現代のAI開発が直面する二つの大きなジレンマがあります。それは、「データの量と質の限界」そして「プライバシー保護の強化」です。

1-1-1. AI開発における「データ格差」問題と実データ入手の限界

AI、特に深層学習モデルは、膨大な量のデータを「食べる」ことで賢くなります。しかし、現実世界でデータを収集するには、多大なコストと時間がかかります。例えば、自動運転AIを訓練するためには、何百万キロもの走行データが必要ですが、その中には事故や危険な状況といった「稀なケース(エッジケース)」はほとんど含まれません。また、収集したデータには、特定の状況や属性に偏りが生じる「バイアス」が含まれることも多く、これがAIの判断を誤らせる原因となります。さらに、医療分野のように、そもそもデータ自体が希少なケースも少なくありません。このように、AI開発に必要な理想的なデータと、現実に手に入るデータとの間には大きな「データ格差」が存在し、多くのプロジェクトがその壁に突き当たっているのです。

1-1-2. 個人情報保護とデータ活用のジレンマを乗り越える鍵

一方で、データ活用に対する社会的な要請はますます厳しくなっています。日本では個人情報保護法、欧州ではGDPR(一般データ保護規則)など、世界各国でプライバシー保護の法規制が強化されています。これにより、企業は顧客データなどの個人情報をAI開発に利用する際、極めて慎重な対応を迫られます。データを匿名化する手法もありますが、完全な匿名化は難しく、再識別されるリスクが常に付きまといます。この「データ活用によるイノベーション」と「プライバシー保護」という二つの要請は、時にトレードオフの関係となり、企業にとって大きなジレンマとなっていました。合成データは、この問題を根本から解決する可能性を秘めています。実在の個人を含まないため、プライバシーリスクを大幅に低減し、これまで活用が難しかった機微なデータ領域でも、安全なAI開発の道を開くのです。

1-2. 合成データの基本:実データとの違いと生成方法

では、合成データとは具体的にどのようなものなのでしょうか。実データとの違いや、その生成方法の基本を見ていきましょう。

1-2-1. 合成データの定義と3つの主要な生成アプローチ

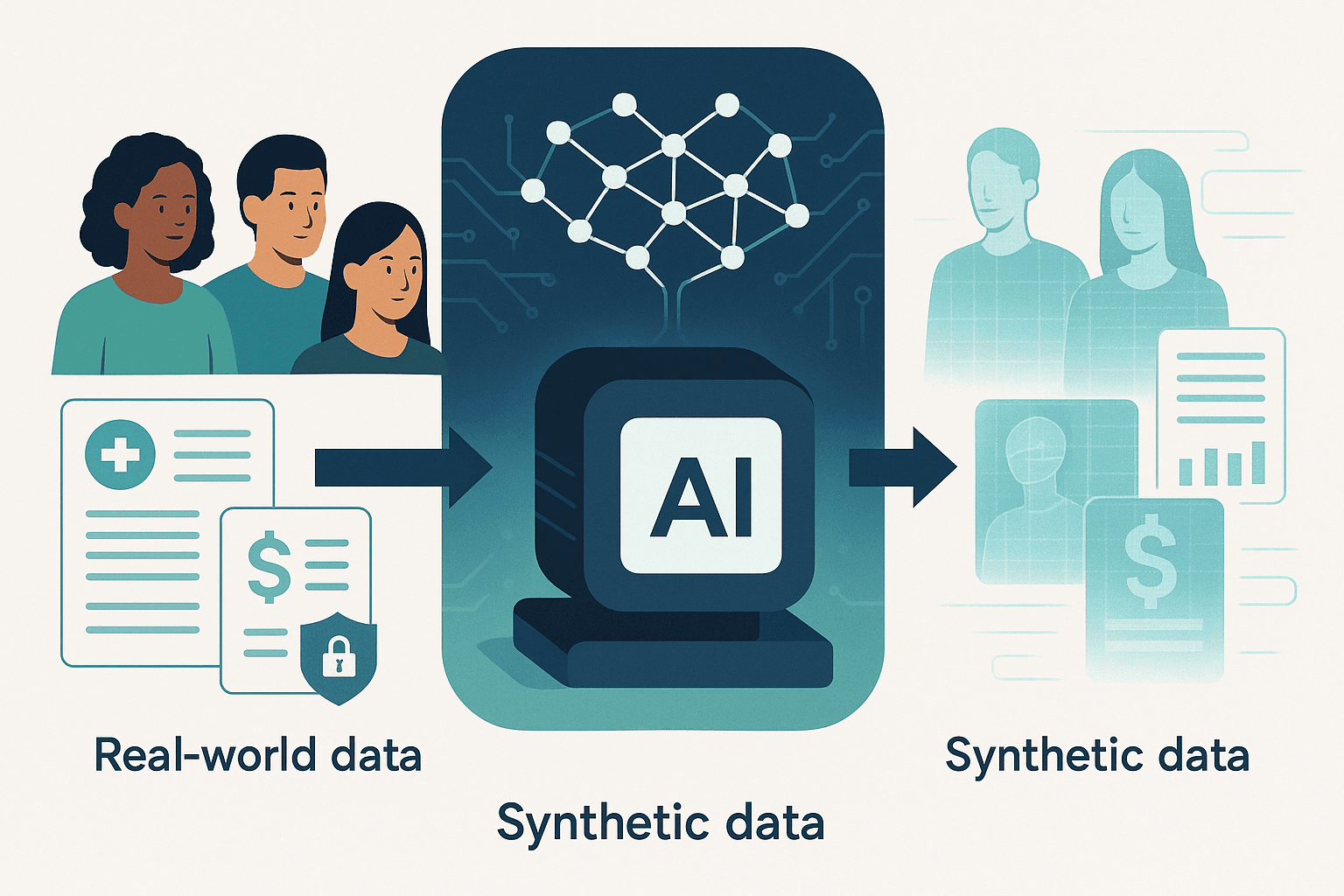

合成データとは、「実世界のデータを収集するのではなく、アルゴリズムや数学モデルを用いて人工的に生成されたデータ」のことです。重要なのは、単なるランダムなデータではなく、実データの統計的な特性やパターンを忠実に模倣している点にあります。これにより、AIモデルは合成データを実データと同じように学習に利用できます。世界経済フォーラムの2025年9月の報告書でも、この新しいデータのフロンティアが詳細に解説されています[1]。 生成アプローチは多岐にわたりますが、主に以下の3つに大別されます。

- 統計的モデリング: 実データの分布(平均、分散など)を分析し、その分布に従う新しいデータを生成する古典的な手法。

- 機械学習モデル: 実データからパターンを学習した機械学習モデル(決定木など)を用いて、新しいデータを生成する手法。

- 深層学習(GANsなど): 生成モデル(特に敵対的生成ネットワーク、GANs)を用いて、実データと見分けがつかないほどリアルなデータを生成する、現在最も注目されている手法。

1-2-2. 「実データにはない価値」を生み出す仕組み

合成データの真価は、単に実データを模倣するだけではありません。むしろ、実データにはない、あるいは入手が困難な価値を意図的に生み出せる点にあります。例えば、自動運転の例で言えば、現実にはめったに起こらない「夜間の豪雨の中、道路に障害物が飛び出してくる」といった危険なシナリオを、合成データなら何万通りでも生成できます。これにより、AIは未知の状況に対する対応能力を格段に向上させることができます。また、データセットに不足している特定の人種や年齢層のデータを意図的に追加生成することで、AIの公平性を高めることも可能です。このように、合成データはデータセットの「量」を増やすだけでなく、「質」を能動的にコントロールし、AIモデルの堅牢性や汎用性を高めるという、実データだけでは成し得なかった新たな価値を提供するのです。

出典: [1] World Economic Forum. (2025, September). Synthetic Data: The New Data Frontier.

合成データ活用領域の比較

2. 【2025年最新】合成データが拓く4つの主要活用領域

合成データは、単なる理論上のコンセプトではありません。すでに様々な業界で、これまで解決が困難だった課題を克服し、イノベーションを加速させる原動力となりつつあります。ここでは、2025年の最新動向として特に注目すべき4つの主要な活用領域を、具体的な事例とともに掘り下げていきます。

2-1. 医療分野:プライバシーを守りながら診断精度を向上

医療分野は、データの機微性が極めて高く、合成データが最も大きなインパクトを与える領域の一つです。患者のプライバシーを厳格に保護しながら、AIによる診断技術の向上や創薬研究を加速させることが期待されています。

2-1-1. 希少疾患の学習データ生成と研究の加速

希少疾患の研究は、症例数が極端に少ないため、十分な学習データを集めることが長年の課題でした。AIモデルを訓練しようにも、データがなければ始まりません。ここで合成データが活躍します。数少ない実データから統計的特徴を学習し、多数のリアルな合成患者データを生成することで、研究者はこれまで不可能だった規模での分析やモデル開発に着手できます。これにより、診断支援AIの精度向上や、新たな治療法の開発サイクルが大幅に短縮されると期待されています。Nature誌の報告によれば、合成データは仮説生成や実験結果の予測にも有用であり、データ収集が困難な状況での研究を大きく前進させる可能性を秘めています[2]。

2-1-2. 医療画像のバリエーション拡充によるAI診断支援

X線やCT、MRIといった医療画像診断においても、合成データは革命をもたらします。例えば、特定の種類の病変を含む画像を大量に生成し、AIの画像認識モデルを訓練することで、診断精度を飛躍的に向上させることができます。さらに、様々な撮影条件下での画像をシミュレーション生成することで、AIは多様な状況に対応できる頑健性を獲得します。これにより、放射線科医の不足が深刻な地域でも、AIが診断を補助し、医療の質の均てん化に貢献することが可能です。患者データを直接利用しないため、HIPAAやGDPRといった厳しいプライバシー規制を遵守しながら、安全に技術開発を進められる点も大きなメリットです[3]。

2-2. 自動運転:安全性を飛躍的に高めるエッジケースの克服

完全自動運転の実現には、AIが人間以上に安全な運転判断を下せることが絶対条件です。そのためには、現実世界ではめったに遭遇しない「エッジケース」への対応能力が不可欠であり、合成データはその訓練に絶大な効果を発揮します。

2-2-1. 危険なシナリオの無限シミュレーションと認識モデルの強化

現実の道路で、子供の飛び出しや対向車のスピンといった危険な状況を意図的に再現し、データを収集することは不可能です。しかし、シミュレーション環境であれば、合成データを用いてこれらの危険なシナリオを文字通り「無限に」生成できます。NVIDIAの「GTC 2025」で発表されたCosmosやIsaac GR00Tといったプラットフォームは、まさにこのシミュレーション駆動型トレーニングを核としています[3]。AIはこれらの膨大な仮想体験を通じて、危険を予測し、回避する能力を安全に学習します。これにより、現実世界でのテスト走行を大幅に削減しつつ、システムの信頼性を極限まで高めることができるのです。

2-2-2. 悪天候や予期せぬ障害物など、現実では稀な状況への対応力向上

自動運転AIの認識システムは、晴天の日中だけでなく、豪雨の夜間、霧の濃い早朝、逆光で見づらい夕暮れ時など、あらゆる環境下で正確に機能しなければなりません。これらの多様な、しかし収集が難しい状況を、合成データは自在に作り出します。天候、時間帯、光の当たり方などをパラメータとして変更し、様々なバリエーションの走行シーンを生成することで、AIの認識モデルはどのような悪条件下でも安定した性能を発揮できるようになります。これにより、自動運転システムの安全性と適用範囲が飛躍的に拡大します。

2-3. 金融サービス:不正検知とリスク管理の高度化

金融業界では、データのセキュリティとプライバシー保護が最優先事項でありながら、データに基づいた高度なリスク管理が求められます。合成データは、この二律背反の課題を解決する切り札として注目されています。

2-3-1. 巧妙化する詐欺パターンの合成データ生成と検知モデルの訓練

クレジットカードの不正利用やオンラインバンキング詐欺など、金融犯罪の手口は日々巧妙化しています。過去のデータだけでは、新しいタイプの不正を検知することは困難です。そこで、最新の詐欺手口を模した合成取引データを生成し、不正検知AIモデルを訓練します。これにより、モデルは未知の攻撃パターンに対する防御能力を獲得し、被害を未然に防ぐことが可能になります。実顧客の取引データを直接使うことなく、モデルを常に最新の状態にアップデートできるため、セキュリティとプライバシーを両立できます。

2-3-2. 人種や性別によるバイアスを排除した公平な与信モデルの構築

AIによる与信審査では、学習データに含まれる歴史的・社会的なバイアスが、特定の属性を持つ人々に対して不公平な判断を下すリスクが指摘されています。例えば、過去のデータにおいて特定の層のデフォルト率が統計的に高かった場合、AIがその傾向を学習し、本来返済能力がある個人に対しても不当に低い評価を下してしまう可能性があります。合成データを用いることで、人種、性別、年齢といった属性のバランスが取れた、理想的なデータセットを構築できます。これにより、バイアスの影響を排除した公平な与信モデルを開発し、金融包摂の実現に貢献することができます。

2-4. LLM・生成AI:モデル性能を加速させる新たな学習方法

ChatGPTに代表される大規模言語モデル(LLM)や生成AIの分野でも、合成データはモデルの性能向上と開発効率化に不可欠な要素となりつつあります。

2-4-1. ファインチューニングと評価データセットの効率的な量産

汎用的なLLMを特定の業務(例えば、法律相談や医療相談)に特化させる「ファインチューニング」には、その専門分野の高品質なQ&Aデータセットが大量に必要です。しかし、専門家が手作業でこれを作成するのは非常にコストがかかります。合成データ技術を使えば、少量のサンプルデータから、多様で質の高い学習データセットを効率的に量産できます。同様に、モデルの性能を多角的に評価するためのテストデータセットも自在に生成でき、開発サイクルを大幅に加速させます[3]。

2-4-2. 「モデル崩壊」を防ぐための多様で高品質なデータ供給源

AIが生成したコンテンツをAIが再び学習すると、次第に品質が劣化し、最終的には無意味な内容しか生成できなくなる「モデル崩壊」という現象が懸念されています。これは、インターネット上のデータがAI生成コンテンツで「汚染」されていく将来において、深刻な問題となり得ます。合成データは、この問題に対する有望な解決策です。人間が監修し、品質を管理した上で生成される合成データは、モデルが多様性と正確性を維持するための「清浄な」データ供給源となります。これにより、AIエコシステムの持続的な発展を支えることができるのです[2]。

出典: [2] Nature. (2025, September 10). Synthetic data can benefit medical research — but risks must be recognized. [3] CleverX. (2025, September 8). Synthetic data for ML: the game-changer in training for 2025.

3. 日本企業が合成データを導入するメリットと実践ステップ

海外の先進事例を見て、合成データの可能性に期待を抱く一方、「自社で導入するにはハードルが高い」と感じる方も多いかもしれません。しかし、合成データは、リソースが限られる中でも、日本企業がデータ活用の壁を乗り越え、競争力を高めるための強力な武器となり得ます。ここでは、導入によって得られる具体的なメリットと、実践に向けたステップを解説します。

3-1. データ入手の壁を越える3つの主要メリット

合成データの導入は、AI開発における長年の課題であったデータに関する問題を、コスト、スピード、コンプライアンスの三つの側面から解決します。

3-1-1. データ収集・加工コストの大幅な削減

実データを収集・加工するプロセスは、AIプロジェクト全体のコストを押し上げる大きな要因です。例えば、アノテーション(教師データ作成)作業には、専門の作業員と多くの時間が必要であり、特に高品質なデータセットを構築しようとすると、その費用は数千万円から数億円に上ることも珍しくありません。合成データは、このプロセスを根本から変革します。一度データ生成環境を構築すれば、アルゴリズムによって低コストで、かつ大規模にデータを生成できます。手作業によるラベリングも不要になるケースが多く、データ準備にかかるコストと時間を劇的に削減することが可能です[3]。

3-1-2. 開発サイクルの短縮と迅速なPoC(概念実証)の実現

従来のAI開発では、データ収集と準備のフェーズがプロジェクト全体のボトルネックとなり、アイデアの検証から実装までに数ヶ月から数年を要することも少なくありませんでした。合成データを用いれば、必要なデータセットを迅速に生成できるため、この開発サイクルを大幅に短縮できます。新しいアイデアが生まれた際も、すぐにPoC(概念実証)に着手し、その有効性を素早く検証することが可能です。このアジリティ(俊敏性)の向上は、変化の速い市場において、競合他社に先んじて新しいサービスや製品を投入するための重要な鍵となります。

3-1-3. 個人情報保護法などの規制を遵守した安全なデータ活用

日本企業にとって、個人情報保護法の遵守は事業継続における絶対条件です。顧客データなどの機微な情報をAI開発に活用したくても、プライバシー侵害のリスクや、匿名化処理の煩雑さから、二の足を踏むケースが多くありました。合成データは、実在の個人に関する情報を一切含まないため、このコンプライアンス上の課題をクリアします。統計的な特徴は維持しつつも、個人が特定されるリスクは極めて低いため、法規制を遵守しながら、これまで活用が難しかった領域のデータも安全にAI開発に利用できます。これにより、企業は法的リスクを恐れることなく、データドリブンなイノベーションを加速させることができるのです。

3-2. 導入に向けた具体的な5つのステップ

合成データの導入を成功させるためには、計画的かつ段階的なアプローチが重要です。以下に、導入に向けた5つの具体的なステップを示します。

3-2-1. ステップ1:課題の特定と合成データ適用の判断

まず、自社のビジネスや開発プロセスにおいて、どのようなデータ課題が存在するのかを明確にします。「学習データが不足している」「希少なケースを網羅できない」「プライバシー規制でデータが使えない」「アノテーションコストが高すぎる」など、具体的な課題を洗い出します。その上で、それらの課題が合成データの活用によって解決可能かどうかを検討します。すべての課題に合成データが有効なわけではないため、費用対効果を見極め、最もインパクトの大きい領域から適用を考えることが成功の第一歩です。

3-2-2. ステップ2:目的に合った生成ツール・プラットフォームの選定

次に、ステップ1で特定した課題とデータの種類(表形式、画像、テキストなど)に応じて、最適な生成ツールやプラットフォームを選定します。後述するように、市場にはK2viewのようなエンタープライズ向け商用プラットフォームから、Syntheaのような特定分野に特化したオープンソースまで、多様な選択肢が存在します[4]。自社の技術力、予算、求めるデータの品質、セキュリティ要件などを総合的に評価し、最適なソリューションを選択することが重要です。初期段階では、コンサルティングサービスを提供しているベンダーに相談するのも良いでしょう。

3-2-3. ステップ3:実データと組み合わせたハイブリッドアプローチの設計

合成データは万能ではなく、実データと組み合わせて使うことで、その効果を最大化できます。CleverXの記事でも推奨されているように、少量の高品質な実データを「シード(種)」として、それを基に合成データを生成し、データセットを拡張するハイブリッドアプローチが一般的です[3]。例えば、基本的なパターンは実データで学習させ、エッジケースや不足している属性のデータは合成データで補う、といった設計が考えられます。実データと合成データの最適なブレンド比率を見つけることが、モデルの性能を最大化する鍵となります。

3-2-4. ステップ4:生成データの品質評価とガバナンス体制の構築

生成した合成データが、AIの学習に耐えうる品質を持っているかを評価するプロセスは不可欠です。「リアリズムの欠如」や「バイアスの増幅」といった問題を避けるため、生成されたデータが実データの統計的分布を正しく反映しているか、また、タスクにとって十分に多様で現実的かを検証します。統計的な比較や可視化ツールを用いた評価に加え、専門家による目視でのレビューも重要です。また、誰が、いつ、どのような目的で、どのデータセットを生成・使用したのかを記録・管理するガバナンス体制を構築し、データのトレーサビリティを確保することも忘れてはなりません。

3-2-5. ステップ5:スモールスタートから始める段階的な展開

最初から全社的な大規模導入を目指すのではなく、まずは特定のプロジェクトや部門でスモールスタートを切り、成功体験を積み重ねていくことが賢明です。PoCを通じて合成データの有効性を実証し、コスト削減効果や開発期間の短縮といった具体的な成果を示すことで、社内の理解と協力を得やすくなります。そこで得られた知見やノウハウを基に、徐々に適用範囲を拡大していくことで、リスクを管理しながら、着実に合成データ活用を組織全体に浸透させていくことができます。

出典: [3] CleverX. (2025, September 8). Synthetic data for ML: the game-changer in training for 2025. [4] LinuxSecurity. (2025, September 19). Top Synthetic Data Generation Tools for AI and Testing in 2025.

4. 注目すべき合成データ生成ツール7選【2025年版】

合成データの導入を検討する上で、適切なツール選定は成功を左右する重要な要素です。現在、市場には様々な特徴を持つツールが登場しており、自社の目的や技術レベルに合わせて最適なものを選択することが可能です。ここでは、2025年現在、特に注目すべき7つの合成データ生成ツールを、「商用プラットフォーム」と「オープンソース」に分けて紹介します。

4-1. 商用プラットフォーム:エンタープライズ向けの強力な選択肢

商用プラットフォームは、手厚いサポートや高度な機能、セキュリティを重視する企業向けの選択肢です。導入から運用までをスムーズに進めたい場合に適しています。

4-1-1. K2view:テストデータ管理も統合したオールインワン型

K2viewは、単なる合成データ生成に留まらず、テストデータ管理やデータマスキングといった周辺機能までを統合したオールインワン・プラットフォームです。特に、大規模なエンタープライズシステムにおけるテスト工程の効率化に強みを持ちます。ノーコードのワークフローを通じて、テスター自身が特定のシナリオに合わせたデータセットを容易に準備できるため、開発とテストのサイクルを高速化します。Gartner社からもその先進性が認められており、データ管理基盤全体を刷新したいと考える大企業にとって、有力な選択肢となるでしょう[4]。

4-1-2. Gretel:開発者フレンドリーなAPIで多様なデータに対応

Gretelは、開発者が自身のパイプラインに容易に組み込めるよう、API中心の設計思想で作られています。表形式のデータからテキスト、JSON、イベントストリームまで、非常に幅広いデータ形式に対応しているのが特徴です。プライバシー保護技術にも注力しており、生成されたデータの安全性を確保しながら、AIや機械学習の研究・開発ワークフローを加速させます。Python SDKも提供されており、データサイエンティストや開発者がコーディングを通じて、きめ細かなデータ生成制御を行いたい場合に特に適しています[4]。

4-1-3. Synthesis AI:人間中心のCVモデルに特化した高忠実度データ

Synthesis AIは、コンピュータビジョン(CV)、特に「人間」が関わるシーンのAIモデル開発に特化したユニークなプラットフォームです。リアルな人間の顔や身体、動きなどをCGで高忠実度に生成し、ラベル付けされた状態で提供します。これにより、自動運転における歩行者認識、スマート店舗での顧客行動分析、AR/VRアプリケーション用の人物インタラクションなど、実データ収集が困難かつ倫理的に配慮が必要な領域でのAI開発を加速させます。人間中心の高度なビジョンAIを開発する企業にとっては、欠かせないツールと言えるでしょう[4]。

4-1-4. MOSTLY AI:公平性アルゴリズムを搭載し、バイアスを低減

MOSTLY AIは、元のデータの統計的特性を維持しつつ、プライバシーを保護した合成データを生成することに長けています。このツールの際立った特徴は、「公平性(Fairness)」を担保するための機能が組み込まれている点です。生成プロセスにおいて、人種や性別といった機微な属性が、結果に不当な影響を与えないように調整し、バイアスの少ないデータセットを作り出すことができます。AIの倫理性が強く問われる現代において、特に金融機関の与信審査や人事採用など、公平性が絶対条件となる領域でその価値を発揮します[4]。

4-1-5. Hazy:金融業界の厳しい規制要件に準拠

Hazyは、特に金融サービス業界のように、規制が厳しく、データの取り扱いに最大限の注意が求められるセクターに特化したプラットフォームです。銀行や保険会社などが直面する、不正検知、マネーロンダリング対策、リスクモデリングといった課題に対し、規制要件を遵守した高品質な合成データを提供します。エンタープライズ向けの堅牢なプラットフォームとして提供されており、セキュリティとコンプライアンスを最優先事項とする金融機関にとって、信頼性の高い選択肢となります[4]。

4-2. オープンソース:コストを抑え、柔軟なカスタマイズを実現

オープンソースのツールは、ライセンス費用がかからず、ソースコードが公開されているため、自社のニーズに合わせて自由にカスタマイズできるのが最大の魅力です。技術力のあるチームにとっては、強力な武器となります。

4-2-1. Synthea:医療分野の合成患者データ生成におけるデファクトスタンダード

Syntheaは、医療分野における合成データ生成ツールとして、世界中の研究者に利用されているオープンソースプロジェクトです。米国の人口統計に基づき、誕生から死亡までの詳細な合成患者記録(病歴、処方、検査結果など)を生成することができます。これにより、研究者は実際の患者情報(PHI)を一切使うことなく、臨床研究や医療情報システムのテスト、教育などに活用できます。医療分野で合成データ活用を始める際の、事実上の標準(デファクトスタンダード)ツールと位置づけられています[4]。

4-2-2. Synthetic Data Vault (SDV):Pythonベースで拡張性の高いライブラリ群

Synthetic Data Vault (SDV)は、MITのデータ・トゥ・AIラボから生まれた、Pythonベースの合成データ生成ライブラリ群です。単一のテーブルだけでなく、複数のテーブルが連携するリレーショナルデータベースや、時系列データなど、複雑なデータ構造に対応できる高い柔軟性と拡張性が特徴です。学術界だけでなく、多くの企業プロジェクトでも利用されており、活発なコミュニティによって開発が続けられています。Pythonでのデータ分析や機械学習に慣れ親しんだチームであれば、比較的容易に導入し、自社のデータに合わせてカスタマイズすることが可能です[4]。

出典: [4] LinuxSecurity. (2025, September 19). Top Synthetic Data Generation Tools for AI and Testing in 2025.

5. 合成データ活用の注意点と倫理的課題

合成データはAI開発に革命をもたらす可能性を秘めていますが、その活用は決して「銀の弾丸」ではありません。導入を成功させ、社会的な信頼を得るためには、技術的な落とし穴と倫理的な課題を深く理解し、慎重に対処することが不可欠です。特に、「生成データの品質」と「プライバシー・説明責任」は、避けては通れない重要な論点です。

5-1. 技術的な落とし穴:「リアリズムの欠如」と「バイアスの増幅」

合成データの品質は、それを用いて開発されるAIモデルの性能に直結します。しかし、生成されたデータが常に実世界を完璧に反映するとは限りません。特に注意すべきは「リアリズムの欠如」と「バイアスの増幅」という二つの技術的なリスクです。

5-1-1. 生成データの品質をいかに評価し、信頼性を担保するか

合成データは、実データの統計的パターンを模倣しますが、現実世界に存在する微妙なニュアンスや、まだ知られていない相関関係を完全には捉えきれない場合があります。これを「リアリズムの欠如」と呼びます。例えば、非常にリアルに見える合成顔画像でも、物理的にありえない影の付き方をしているかもしれません。このようなデータで学習したAIは、実世界のデータに直面した際に、予期せぬエラーを起こす可能性があります。このリスクを軽減するためには、生成されたデータを厳格に評価し、その信頼性を担保する仕組みが不可欠です。統計的な指標だけでなく、専門家による目視での評価や、実世界のホールドアウトデータ(評価用に確保しておいた実データ)でモデルの最終的な性能を検証することが極めて重要になります[3]。

5-1-2. 元データに潜むバイアスを再生産・増幅させないための対策

合成データは、元となる実データ(シードデータ)に含まれるバイアスを学習してしまいます。問題は、単にバイアスを再生産するだけでなく、それをさらに「増幅」させてしまう危険性があることです。例えば、元のデータに特定の性別や人種が少なく、AIがそれを「重要でない特徴」と誤って学習した場合、合成データを生成する過程でその傾向がさらに強調され、マイノリティグループがデータセットから事実上消えてしまう可能性すらあります。これを防ぐためには、元データのバイアスを事前に分析し、合成データの生成過程で公平性を担保するアルゴリズム(例:MOSTLY AIの機能)を導入したり、意図的に不足しているデータを補うように生成プロセスを制御したりする対策が求められます。

5-2. 倫理的・法規制上の考慮事項

合成データはプライバシーリスクを低減しますが、ゼロにするわけではありません。また、AIの判断が社会に与える影響が大きくなるにつれて、その倫理的な側面や法規制上の課題も浮上してきます。

5-2-1. プライバシーは本当に保護されるのか?再識別リスクへの備え

「合成データは個人の情報を含まないから安全だ」と単純に考えるのは危険です。特に、元データと非常に近い統計的特性を持つ高忠実度な合成データを生成した場合、他の情報と組み合わせることで、元データに含まれていた個人が「再識別」されるリスクが皆無とは言えません。Nature誌の記事でも、AIモデルの生成に使用されたデータから個人が特定されるリスクについて警鐘が鳴らされています[2]。このため、一部の研究機関では、合成データを用いた研究であっても倫理審査を求める動きが出てきています。企業は、差分プライバシーのようなプライバシー保護技術を生成プロセスに組み込む、アクセス管理を徹底するなど、再識別リスクに対する技術的・組織的な備えを講じる必要があります。

5-2-2. AIの判断根拠を示す「説明責任」とデータの「トレーサビリティ」確保の重要性

AIが下した判断(例えば、ローンの審査否決)について、その理由を人間が理解できる形で説明することは「説明責任(Explainability)」と呼ばれ、AI倫理の重要な要素です。AIの学習に合成データを用いた場合、その判断の根拠が、実データに由来するものなのか、合成データ特有のアーティファクト(人工的な産物)によるものなのかを区別することが難しくなる可能性があります。このため、いつ、誰が、どの実データを基に、どのようなアルゴリズムとパラメータで合成データを生成したのか、そしてそのデータがどのAIモデルの学習に使われたのか、という一連の来歴を追跡できる「トレーサビリティ」の確保が不可欠です。厳格なガバナンス体制を構築し、データの透明性を保つことが、社会からの信頼を得るための鍵となります。

出典: [2] Nature. (2025, September 10). Synthetic data can benefit medical research — but risks must be recognized. [3] CleverX. (2025, September 8). Synthetic data for ML: the game-changer in training for 2025.

6. まとめ:合成データはAI活用の新たな標準へ

本記事では、2025年における生成AI活用の最前線として、「合成データ」に焦点を当て、その基本概念から具体的な活用領域、導入ステップ、そして倫理的課題までを網羅的に解説しました。AI開発における「データの壁」と「プライバシー保護」という二大ジレンマを解決する鍵として登場した合成データは、もはや一部の先進企業だけのものではありません。医療分野での診断精度向上、自動運転の安全性強化、金融サービスの高度化、そしてLLM自体の性能向上に至るまで、その応用範囲は急速に拡大しています。日本企業にとっても、データ収集コストの削減、開発サイクルの短縮、そして個人情報保護法の遵守といった、計り知れないメリットをもたらします。市場にはK2viewのような商用プラットフォームからSyntheaのようなオープンソースまで、多様なツールが存在し、スモールスタートからでも導入を始めることが可能です。もちろん、「バイアスの増幅」や「再識別リスク」といった課題も存在し、その導入には慎重なガバナンス体制が不可欠です。しかし、これらの課題を乗り越えた先には、データ活用の新たな地平が広がっています。Gartnerが予測するように、2030年には合成データがAIトレーニングの主流となる未来は、もう目前に迫っています。この大きな変革の波に乗り遅れないために、まずは自社のデータ課題を再点検し、合成データがどのように貢献できるか、その第一歩を検討してみてはいかがでしょうか。

よくある質問(Q&A)

Q1: 合成データは、本当に実データの代わりになるのでしょうか?品質は信頼できますか?

A1: はい、多くの場合で実データの有効な代替、あるいは補完となりますが、品質の信頼性確保が鍵となります。合成データは、実データの統計的特性を忠実に模倣するように設計されており、特にGANs(敵対的生成ネットワーク)のような高度な技術を用いることで、実データと見分けがつかないほどリアルなデータを生成できます。しかし、その品質は生成モデルの性能や元となるデータに依存します。そのため、生成されたデータが現実世界の複雑さや微妙なニュアンスを捉えきれているか(リアリズム)、元データに含まれるバイアスを増幅していないか、といった点を厳格に評価するプロセスが不可欠です。実用上は、100%合成データに置き換えるのではなく、少量の実データと大量の合成データを組み合わせる「ハイブリッドアプローチ」が、モデルの性能と堅牢性を最大化する上で最も効果的です。信頼性を担保するためには、本記事で解説した「品質評価とガバナンス体制の構築」が極めて重要になります。

Q2: 合成データを導入したいのですが、何から始めればよいでしょうか?専門的な知識がなくても可能ですか?

A2: 専門知識がなくても、スモールスタートで始めることは十分に可能です。最初のステップとして、まずは自社のビジネス課題を明確にし、「データが足りない」「プライバシーの問題でデータが使えない」といった具体的なペインポイントを特定することから始めましょう。次に、その課題解決に合成データが有効かを検討します。もし有効だと判断できれば、GretelやMOSTLY AIのような、比較的ユーザーフレンドリーな商用プラットフォームのトライアルを利用してみるのが良いでしょう。これらのツールは、専門家でなくてもGUI(グラフィカル・ユーザー・インターフェース)を通じて、手持ちのデータをアップロードし、合成データを生成・評価できる機能を備えています。まずは特定の小さなプロジェクトでPoC(概念実証)を行い、コスト削減や開発効率化などの具体的な成果を出すことで、社内の理解を得ながら段階的に活用を広げていくのが成功への近道です。

Q3: 合成データを使えば、個人情報保護法やGDPRなどの規制を完全に無視できるのでしょうか?

A3: いいえ、完全に無視することはできません。合成データは実在の個人を含まないため、プライバシーリスクを「大幅に低減」しますが、リスクがゼロになるわけではありません。特に、元のデータセットと非常によく似た高忠実度の合成データを生成した場合、他の公開情報と組み合わせることで、元のデータに含まれていた個人が推測されてしまう「再識別」のリスクが理論的には残ります。そのため、合成データであっても、それがどのような元データから、どのようなプロセスを経て生成されたのかを管理するガバナンス体制は依然として重要です。差分プライバシーのような数学的なプライバシー保証技術を組み込んだツールを選ぶ、アクセス権を適切に管理するといった対策は必要です。法規制を「無視」するのではなく、「遵守しやすくするための強力なツール」と捉えるのが正しい理解です。

用語集

- 合成データ (Synthetic Data)

- 実世界のデータを収集するのではなく、アルゴリズムや数学モデルを用いて人工的に生成されたデータ。実データの統計的な特性やパターンを模倣しており、AIの学習などに利用される。

- 敵対的生成ネットワーク (GANs - Generative Adversarial Networks)

- データを生成する「生成者(Generator)」と、そのデータが本物か偽物かを見分ける「識別者(Discriminator)」を競わせることで、非常にリアルなデータを生成する深層学習モデルの一種。

- エッジケース (Edge Case)

- 通常の利用状況ではめったに発生しない、例外的または極端な状況やシナリオ。自動運転における危険な状況などがこれにあたる。

- ファインチューニング (Fine-tuning)

- 大規模なデータセットで事前に訓練された汎用的なAIモデルを、特定のタスクや専門分野に合わせて、追加のデータで再トレーニングし、性能を最適化すること。

- モデル崩壊 (Model Collapse)

- AIが生成したコンテンツをAIが再学習し続けることで、データの多様性が失われ、品質が徐々に劣化していく現象。

- 差分プライバシー (Differential Privacy)

- データセットに個人の情報が含まれているかどうかを、統計的に区別できないようにすることで、個人のプライバシーを数学的に保証する技術。

- トレーサビリティ (Traceability)

- あるデータが、いつ、誰によって、どのようなプロセスを経て生成・加工されたのかを追跡できる能力。データの信頼性と説明責任を確保するために重要。