スマホで大規模AIが動く!1ビット量子化の衝撃

目次

2025年9月、AI業界に衝撃が走りました。富士通が、AIモデルのメモリ消費量を最大94%削減し、速度を3倍にする新技術を発表したのです。その核心は「1ビット量子化」。これまで不可能とされてきた「軽量化」と「高精度」の両立を実現し、スマートフォンで大規模AIが動く時代を現実のものとしました。この記事を読めば、AI開発の最前線で今何が起きているのか、そしてこの技術革新が拓く新たなビジネスチャンスとは何か、そのすべてが分かります。AIの次のトレンドを、誰よりも早く掴みましょう。

1. 生成AIの新たな地平:富士通が切り拓く「1ビット量子化」の世界

1-1. 生成AIが直面する「エネルギー問題」という壁

生成AIの進化は、私たちの想像をはるかに超える速度で進んでいます。しかし、その驚異的な能力の裏側で、深刻な課題が浮き彫りになっています。それが、AIモデルの大規模化に伴う消費電力の爆発的な増大です。近年のAIモデルは、パラメータ数を数十億、数百億と増やすことで性能を向上させてきましたが、これは同時に、学習や推論に必要な計算量を増大させ、膨大な電力を消費する結果を招いています。特に、高性能なGPUを多数搭載したデータセンターは、AI開発の根幹を支える一方で、「電力を大量に消費する施設」としての側面も持っています。このままモデルの巨大化が進めば、電力供給の限界や、それに伴うコストの増大が、AI技術の持続的な発展を阻害する大きな要因になりかねません。AIが社会の隅々にまで浸透し、その恩恵を誰もが享受できる未来を実現するためには、このエネルギー問題の克服が不可欠と言えるでしょう。

1-2. 富士通の新技術「生成AI再構成技術」とは?

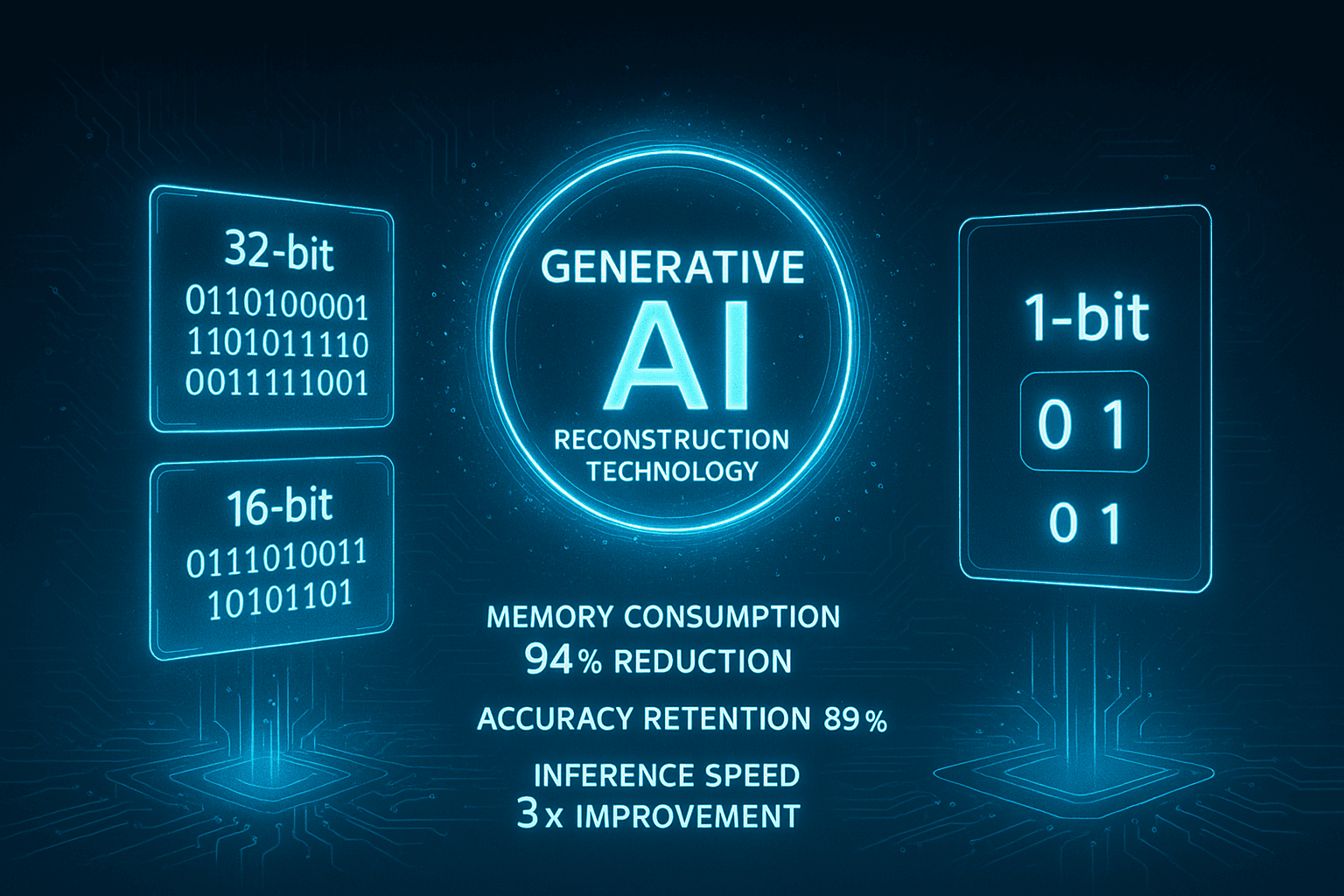

増大し続けるAIの消費電力問題に対し、日本の技術が画期的な解決策を提示しました。富士通が開発した「生成AI再構成技術」の中核をなす「1ビット量子化技術」は、まさにゲームチェンジャーと呼ぶにふさわしい革新性を秘めています。量子化とは、AIモデルが扱う数値の精度を意図的に下げることで、計算に必要なメモリ量や消費電力を削減する技術です。従来、AIモデルは32ビットや16ビットといった高い精度の数値で計算されていましたが、これをわずか「1ビット」、つまり0か1かの二値で表現しようというのが1ビット量子化の考え方です。これにより、理論上はメモリ消費量を大幅に削減できますが、一方で精度の著しい低下という大きな課題がありました。しかし、富士通は独自の技術でこの課題を克服。世界最高精度をうたう1ビット量子化技術を確立し、AIの軽量化と省電力化に新たな道を切り拓いたのです。これは、AIを特別な計算機の上だけでなく、より身近なデバイスで動かすための重要な一歩と言えるでしょう。

富士通の1ビット量子化技術の概念図

2. 精度89%維持の衝撃:1ビット量子化が実現する「軽量・高速AI」

2-1. 従来の量子化技術(GPTQ)との圧倒的な差

富士通が達成した精度維持率89%という数字は、AI開発の歴史において特筆すべき成果です。なぜなら、これまで主流とされてきた量子化技術「GPTQ」では、精度維持率は20%以下に留まるのが常識だったからです。GPTQは、学習後のモデルに対して量子化を行う「Post-Training Quantization(PTQ)」の一種であり、比較的容易にモデルを軽量化できる反面、特に1ビットのような極端な低ビット量子化では、情報の損失が大きく、AIの性能が著しく劣化するという致命的な欠点を抱えていました。多くの研究者がこの「20%の壁」に挑んできましたが、抜本的な解決には至っていませんでした。この状況を打破したのが、富士通の独自アプローチです。彼らは、単に計算のビット数を減らすだけでなく、量子化に伴う誤差そのものを最小化するための新たなアルゴリズムを開発。これにより、情報の損失を極限まで抑え込み、1ビットという制約の中でもモデルが本来持つ知識と性能を維持することに成功したのです。これは、従来の延長線上にはない、まさにパラダイムシフトと呼べる発想の転換でした。

2-2. メモリ94%削減、速度3倍がもたらすインパクト

富士通の技術がもたらす「メモリ消費量94%削減」と「推論速度3倍」という成果は、単なる性能向上以上の、計り知れないインパクトを持っています。特に注目すべきは、これまで4枚の高性能GPUを必要としていた規模のAIモデルが、わずか1枚のGPUで高速に動作可能になったという点です。これは、AIを動かすためのハードウェア要件を劇的に引き下げることを意味します。これまで、最先端の生成AIを利用できるのは、大規模なデータセンターを持つ一部の巨大IT企業や、高価な計算資源に投資できる研究機関に限られていました。しかし、この技術革新により、中小企業や個人の開発者、さらには大学の研究室レベルでも、高性能なAIをより手軽に活用できる道が開かれます。AI開発の民主化が一気に加速し、これまでにはなかったような多様な主体から、革新的なアイデアやアプリケーションが生まれる土壌が育まれることになるでしょう。AIイノベーションの裾野が大きく広がる、まさにその転換点に私たちはいるのです。

従来技術との性能比較グラフ

3. スマホで動く大規模AI:エッジAI時代の本格到来

3-1. 「オンデバイスAI」がもたらすメリット

富士通の軽量化技術は、AIの活躍の場をクラウドから私たちの手元にあるデバイス、すなわち「エッジ」へと大きく広げます。これが「オンデバイスAI」時代の本格的な幕開けです。最大のメリットは、その圧倒的な応答性にあります。クラウド上のAIを利用する場合、データを送信し、処理結果を受信するまでに、どうしても通信の遅延(レイテンシ)が発生します。しかし、オンデバイスAIでは、スマートフォンやPC、自動車などのデバイス内部でAIが思考するため、この遅延がほぼゼロになります。これにより、例えば、AR(拡張現実)グラスに映る風景にリアルタイムで情報を付加したり、工場のロボットアームが瞬時に異常を検知して動作を停止したりといった、即時性が求められるアプリケーションが格段にスムーズになります。さらに、インターネット接続が不安定な場所や、そもそも接続できない環境でもAIを利用できるため、山間部のインフラ点検や災害現場での救助活動など、活用の幅は無限に広がっていくでしょう。

エッジAI時代の到来

3-2. 産業・社会インフラへの応用シナリオ

オンデバイスAIの実用化は、特に産業分野において大きな変革をもたらします。例えば、製造業の工場では、生産ラインに設置されたカメラが、製品の微細な傷や組み立てのズレをリアルタイムで検知し、不良品の流出を未然に防ぐといった活用が考えられます。クラウドAIでは難しかったミリ秒単位の高速な判断が可能になるため、生産性の向上と品質管理の高度化に大きく貢献するでしょう。また、自動運転の分野では、車両に搭載されたAIが、周囲の歩行者や障害物を瞬時に認識し、衝突を回避する判断を下します。通信状況に左右されずに安定した判断ができるオンデバイスAIは、安全性が絶対条件となる自動運転システムにおいて不可欠な技術です。その他にも、ドローンによるインフラ設備の点検や、農業における作物の生育状況の自動診断など、これまで人手に頼らざるを得なかった多くの現場作業を、AIが自律的に支援する未来が現実のものとなります。

エッジAIの応用分野

4. 世界のAI開発競争と日本の現在地

4-1. 米国・中国のAIチップ開発動向

現在のAI開発、特に大規模言語モデルの学習において、米Nvidia社のGPUが市場をほぼ独占していることは周知の事実です。その圧倒的な計算能力は、AIの進化を牽引してきましたが、同時に、一企業への過度な依存は、供給の不安定性や価格高騰といったリスクもはらんでいます。この状況に変化をもたらそうと、今、最も積極的に動いているのが中国です。米国の半導体輸出規制という逆風をバネに、AlibabaやBaiduといった巨大IT企業が、Nvidiaへの依存から脱却すべく、自社でのAIチップ開発を急ピッチで進めています。彼らは、米国の規制対象とならない範囲で独自のチップを設計・製造し、実際に自社のAIモデルの学習に投入し始めています。これは、単なるコスト削減や安定供給の確保に留まらず、米国の技術的覇権に対する挑戦であり、世界のAI開発の勢力図を塗り替えかねない大きな動きです。Nvidiaの牙城は依然として強固ですが、その足元では確実に地殻変動が始まっているのです。

世界のAI開発競争

4-2. 富士通の技術が持つ国際的な競争優位性

米中のAIチップ開発競争が激化する中で、富士通の「生成AI再構成技術」は、独自のポジションから国際的な競争優位性を確立しようとしています。その強みは、単にハードウェア(チップ)の性能を追求するのではなく、ソフトウェア(アルゴリズム)との緊密な連携によって、システム全体としての価値を最大化している点にあります。1ビット量子化というソフトウェア技術で計算量を劇的に削減し、それを効率的に実行するためのハードウェアを組み合わせるというアプローチは、チップの微細化や性能向上だけに頼る開発競争とは一線を画します。これは、長年にわたりスーパーコンピュータ「富岳」などの大規模計算システムを手がけてきた富士通ならではの、ハードとソフトの両面を深く理解しているからこそ可能な戦略です。チップ単体の性能でNvidiaに真正面から挑むのではなく、AIの「軽量化」という新たな価値軸を打ち出すことで、エッジAIという巨大な潜在市場で主導権を握ることを狙っています。この総合力こそが、日本の技術が世界で再び輝くための鍵となるでしょう。

5. 開発者が知るべき「軽量AI」活用の勘所

5-1. これからのAIアプリケーション開発の変化

富士通の1ビット量子化技術の登場は、AIアプリケーション開発者にとって、モデル選定の基準を根底から覆すほどのインパクトを持っています。これまでは、まず最高の精度を誇る大規模なモデルを選び、それをいかにして限られた計算資源で動かすか、というアプローチが一般的でした。しかし今後は、「どのデバイスで、どのような応答速度が求められるか」という、アプリケーションの最終的な実行環境を起点として、最適なモデルサイズと量子化のレベルを決定するという、新たな視点が重要になります。つまり、やみくもに巨大なモデルを目指すのではなく、タスクの要求仕様を満たす「必要十分」な性能を、最も効率的な形で実現する設計思想が求められるのです。開発者は、モデルの精度だけでなく、メモリ消費量、推論速度、消費電力といった指標を総合的に評価し、トレードオフを考慮しながら最適なモデルを選定・チューニングするスキルが不可欠となるでしょう。これは、AI開発がより一層、実用性とビジネス価値を重視するフェーズに入ったことを示しています。

5-2. ビジネスパーソンが捉えるべき事業機会

AIの軽量化は、技術者だけの問題ではなく、新たなビジネスチャンスを模索するすべてのビジネスパーソンにとって、またとない好機です。これまで計算資源の制約から「実現不可能」と諦められていたアイデアが、一気に現実味を帯びてくるからです。例えば、オフライン環境で動作する高機能な翻訳デバイス、個人の表情や声のトーンから感情を読み取って対話するコンパニオンロボット、購入前の家具を実物大で自宅にAR表示し、そのままECサイトで購入できるアプリケーションなど、アイデア次第で無限の可能性が広がります。重要なのは、「もしスマートフォンで大規模AIがサクサク動いたら、どんな新しい顧客体験を提供できるか?」という視点で、既存の常識にとらわれずに発想することです。特に、リアルタイム性、プライバシー保護、オフライン利用といったオンデバイスAIの強みを活かせる領域に、大きな事業機会が眠っているはずです。

まとめ

今回解説した富士通の「生成AI再構成技術」は、AI開発の常識を覆す可能性を秘めた技術革新です。中核となる「1ビット量子化」は、AIモデルの計算精度を極限まで単純化しながらも、「特化型AI蒸留」との組み合わせで精度低下を89%に抑えるという驚異的な成果を達成しました。これは、従来技術の精度維持率20%の壁を大きく打ち破るものです。結果として、メモリ消費量を最大94%削減し、推論速度を3倍に高速化。これまで大規模なGPUクラスタを必要とした高性能AIが、わずか1枚のGPU、さらにはスマートフォンなどのエッジデバイスで動作する道を開きました。この技術は、AIの巨大化に伴う消費電力問題への明確な回答であり、AI開発の方向性を「大きさ」から「効率」へと転換させる、まさにパラダイムシフトの始まりと言えるでしょう。今後のAIアプリケーション開発は、この軽量化技術を前提とした新たなステージへと移行していくことが予想されます。

よくある質問(Q&A)

Q1. 「1ビット量子化」とは、初心者にもわかるように言うとどういうことですか?

A1. はい、例えるなら、AIが物事を考えるときの「言葉の細かさ」を調整する技術です。従来のAIは「とても熱い」「やや熱い」「ぬるい」といった多くの段階で温度を表現していましたが、1ビット量子化では「熱い」か「熱くない」かの2択で表現するようなイメージです。これにより、AIが使う脳のメモリ(記憶領域)やエネルギー(電力)を大幅に節約できます。富士通の技術のすごいところは、この表現を非常にシンプルにしながらも、AIの賢さ(精度)をほとんど落とさずに済む点にあります。

Q2. この技術が普及すると、私たちの生活にどんな良いことがありますか?

A2. 大きく分けて3つのメリットが期待できます。第一に、AIがスマートフォンや自動車など、もっと身近な機器でサクサク動くようになります。通信なしで使えるので、災害時などでも安心です。第二に、個人の顔写真や健康情報といったプライベートなデータを、外部のサーバーに送ることなくAIが処理できるため、プライバシーがより安全に守られます。第三に、AIを動かすための電力が大幅に減るため、環境に優しく、電気代の節約にも繋がります。より安全で便利なAIが、生活のあらゆる場面で活躍する未来が近づきます。

Q3. 日本のAI技術は世界と比べて遅れていると聞きますが、この技術はすごいことなのでしょうか?

A3. はい、非常に画期的で、世界に誇れる成果です。確かに、AIモデルの規模の大きさでは米国や中国が先行している面もあります。しかし、富士通の技術は、AIの「大きさ」ではなく「賢さと効率」を追求する、全く新しいアプローチで世界をリードする可能性を秘めています。AIの消費電力問題は世界共通の課題であり、この「軽量化」技術は、その解決策として大きな注目を集めています。日本の「ものづくり」の強みである、品質と効率を追求する精神が、AIという最先端分野で大きな競争力になることを示す好例と言えるでしょう。